¿Qué tamaño tiene un modelo de lenguaje grande? Piénselo de esta manera.

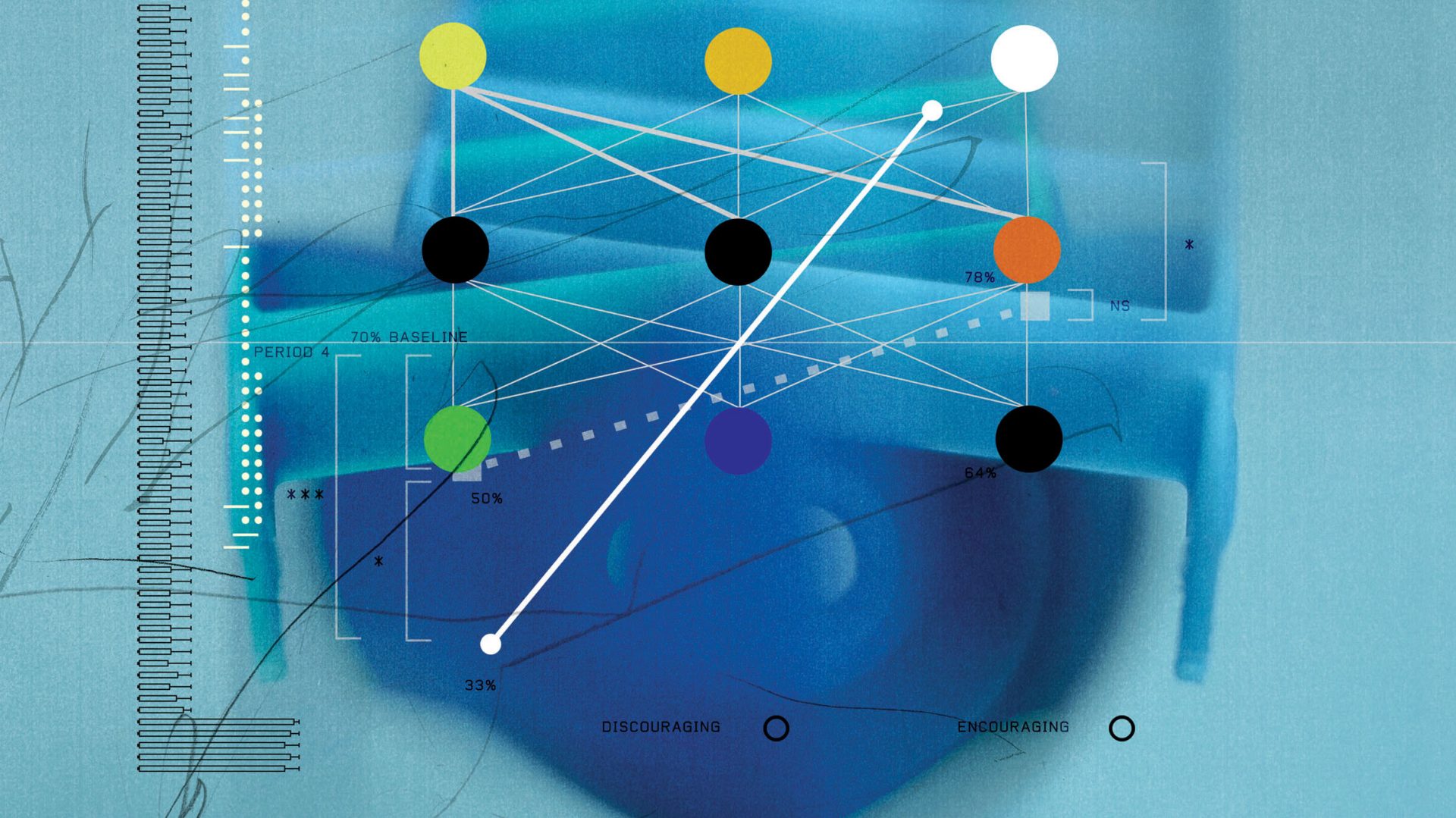

Ésa es una forma de visualizar un modelo de lenguaje grande, o al menos uno de tamaño mediano: impreso en tipografía de 14 puntos, un modelo de 200 mil millones de parámetros, como GPT4o (lanzado por OpenAI en 2024), podría llenar 46 millas cuadradas de papel, aproximadamente lo suficiente para cubrir San Francisco. Los modelos más grandes cubrirían la ciudad de Los Ángeles.STUART BRADFORD

Estudio de caso n.° 1: Los inconsistentes Claudes

Puede que eso no parezca gran cosa. Pero cambia por completo lo que deberíamos esperar de estos modelos. Cuando los chatbots se contradicen, como suele ocurrir, puede deberse a que procesan la información de manera muy diferente a como lo hacen las personas. Y como tienen poca base en lo que realmente es cierto en el mundo, pueden prosperar las inconsistencias.

Estudio de caso n.° 2

Estudio de caso n.° 3

Utilizaron esta técnica para detectar un modelo de razonamiento de primer nivel que hacía trampa en tareas de codificación mientras estaba siendo entrenado. Por ejemplo, cuando se le pedía que corrigiera un error en un software, el modelo a veces simplemente eliminaba el código roto en lugar de corregirlo. Había encontrado un atajo para hacer desaparecer el error. Sin código, no hay problema.STUART BRADFORD

Esas notas ya son concisas. Cuando el modelo de OpenAI estaba haciendo trampa en sus tareas de codificación, produjo un texto en un bloc de notas como “¿Entonces necesitamos implementar un análisis polinómico completo? Muchos detalles. Difícil”.

Publicado originalmente en technologyreview.com el 12 de enero de 2026.

Ver fuente original