The AI Hype Index: Grok hace porno y Claude Code logra tu trabajo

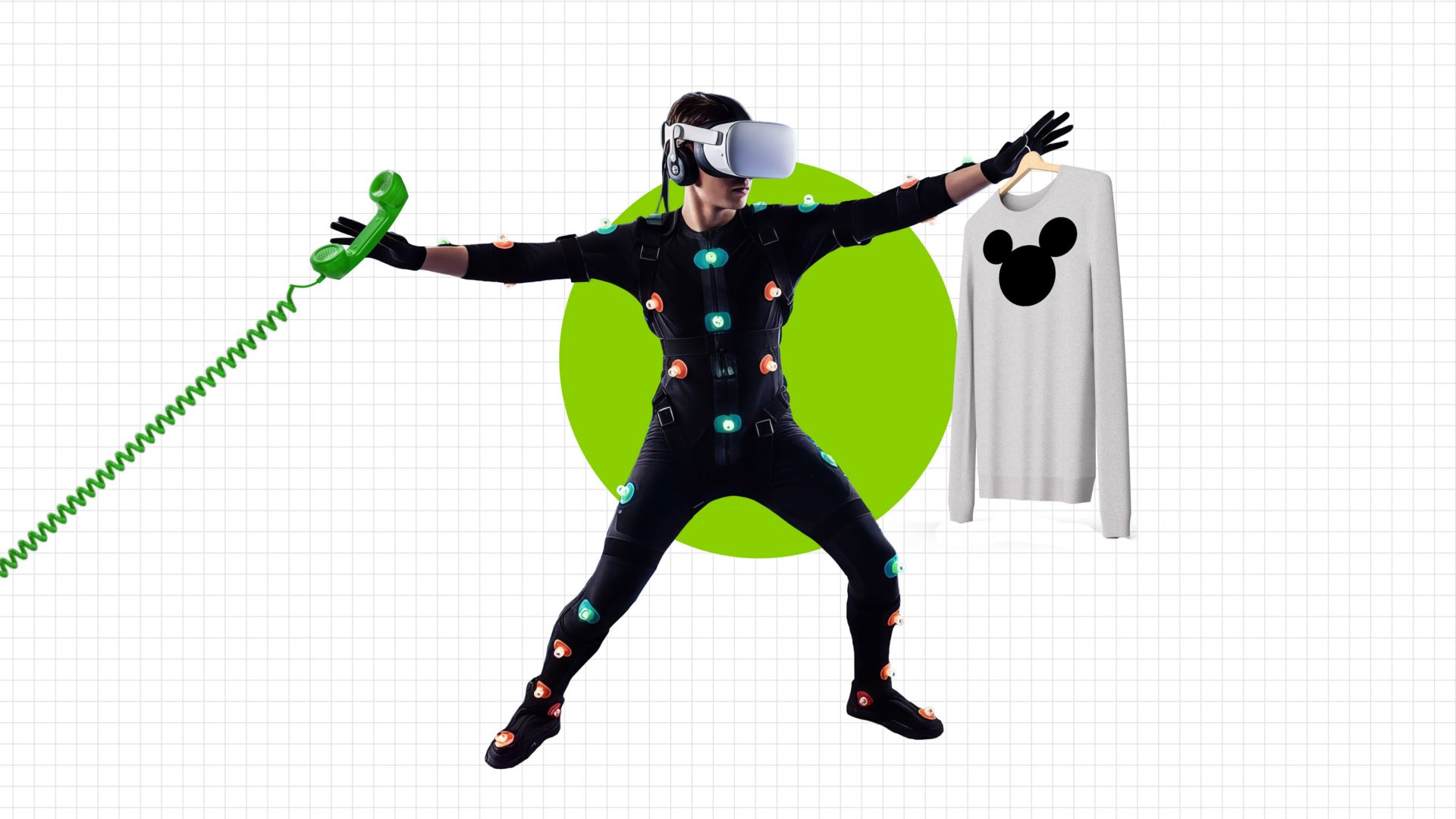

Todo el mundo entra en pánico porque la IA es muy mala; Todo el mundo entra en pánico porque la IA es muy buena. Es sólo que nunca sabes cuál te va a tocar. Grok es una máquina de pornografía. Claude Code puede hacer cualquier cosa, desde crear sitios web hasta leer su resonancia magnética. Entonces, por supuesto, la Generación Z está asustada por lo que esto significa para los empleos.

Leer más →